Guardrails

Le bloc Guardrails valide et protège vos flux de travail IA en vérifiant le contenu selon plusieurs types de validation. Assurez la qualité des données, prévenez les hallucinations, détectez les PII et imposez des exigences de format avant que le contenu ne circule dans votre flux de travail.

Aperçu

Le bloc Guardrails vous permet de :

Valider la structure JSON : garantir que les sorties LLM sont en JSON valide avant l'analyse

Correspondre aux modèles Regex : vérifier que le contenu correspond à des formats spécifiques (emails, numéros de téléphone, URLs, etc.)

Détecter les hallucinations : utiliser le scoring RAG + LLM pour valider les sorties IA par rapport au contenu de la base de connaissances

Détecter les PII : identifier et éventuellement masquer les informations personnellement identifiables à travers plus de 40 types d'entités

Types de validation

Validation JSON

Vérifie que le contenu est correctement formaté en JSON. Parfait pour s'assurer que les sorties LLM structurées peuvent être analysées en toute sécurité.

Cas d'utilisation :

- Valider les réponses JSON des blocs Agent avant l'analyse

- S'assurer que les charges utiles API sont correctement formatées

- Vérifier l'intégrité des données structurées

Output:

passed:truesi le JSON est valide,falsesinonerror: Message d'erreur si la validation échoue (par ex., "JSON invalide : Token inattendu...")

Validation Regex

Vérifie si le contenu correspond à un modèle d'expression régulière spécifié.

Cas d'utilisation :

- Valider les adresses email

- Vérifier les formats de numéros de téléphone

- Vérifier les URLs ou identifiants personnalisés

- Imposer des modèles de texte spécifiques

Configuration :

- Modèle Regex : L'expression régulière à faire correspondre (par ex.,

^[a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+\.[a-zA-Z]{2,}$pour les emails)

Output:

passed:truesi le contenu correspond au modèle,falsesinonerror: Message d'erreur si la validation échoue

Détection d'hallucination

Utilise la génération augmentée par récupération (RAG) avec notation par LLM pour détecter quand le contenu généré par l'IA contredit ou n'est pas fondé sur votre base de connaissances.

Comment ça fonctionne :

- Interroge votre base de connaissances pour obtenir un contexte pertinent

- Envoie à la fois la sortie de l'IA et le contexte récupéré à un LLM

- Le LLM attribue un score de confiance (échelle de 0 à 10)

- 0 = Hallucination complète (totalement non fondée)

- 10 = Entièrement fondé (complètement soutenu par la base de connaissances)

- La validation réussit si le score ≥ seuil (par défaut : 3)

Configuration :

- Base de connaissances : Sélectionnez parmi vos bases de connaissances existantes

- Modèle : Choisissez un LLM pour la notation (nécessite un raisonnement solide - GPT-4o, Claude 3.7 Sonnet recommandés)

- Clé API : Authentification pour le fournisseur LLM sélectionné (masquée automatiquement pour les modèles hébergés/Ollama)

- Seuil de confiance : Score minimum pour réussir (0-10, par défaut : 3)

- Top K (Avancé) : Nombre de fragments de base de connaissances à récupérer (par défaut : 10)

Output:

passed:truesi le score de confiance ≥ seuilscore: Score de confiance (0-10)reasoning: Explication du LLM pour le scoreerror: Message d'erreur si la validation échoue

Cas d'utilisation :

- Valider les réponses des agents par rapport à la documentation

- Assurer que les réponses du support client sont factuellement exactes

- Vérifier que le contenu généré correspond au matériel source

- Contrôle qualité pour les applications RAG

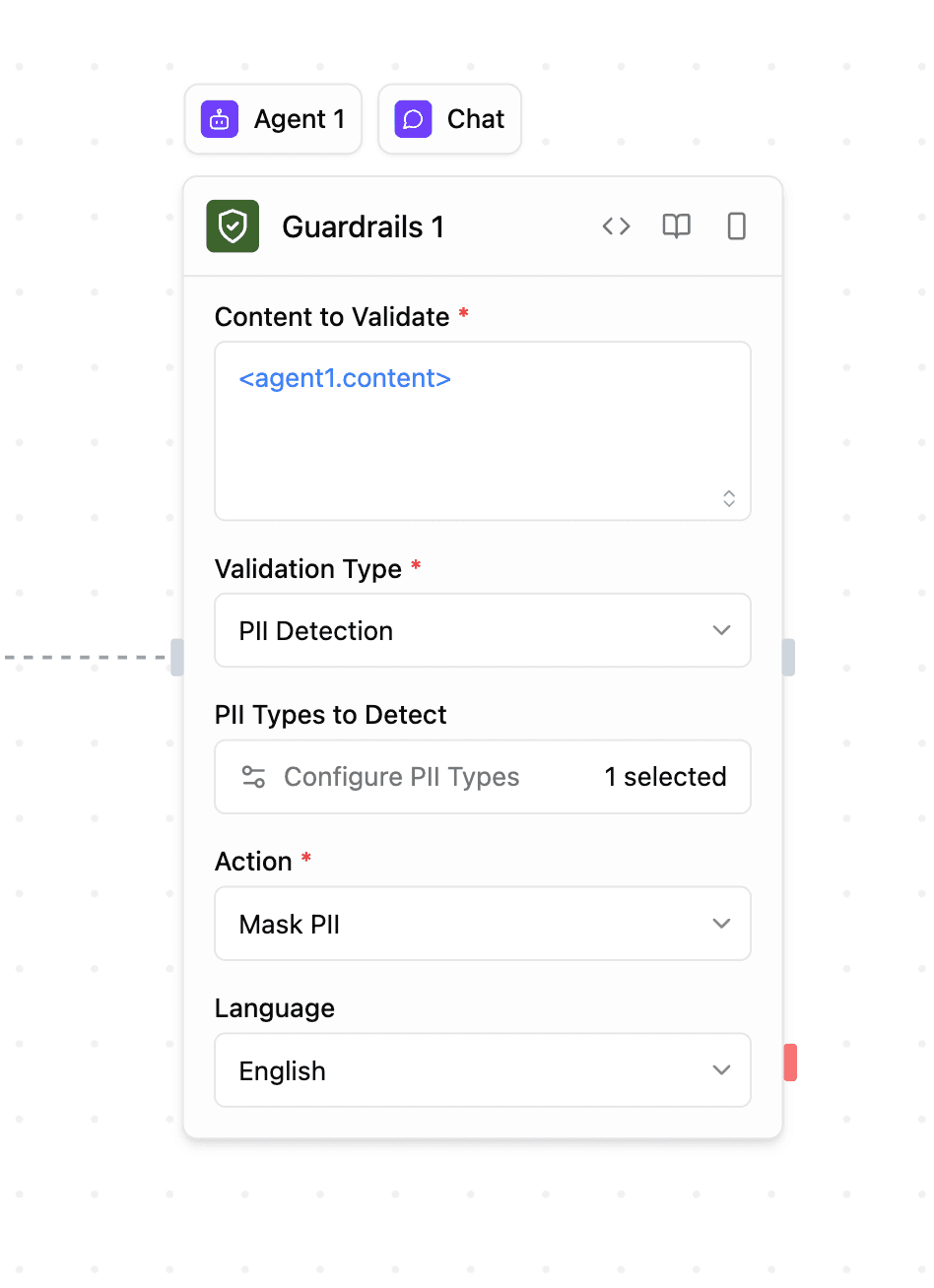

Détection de PII

Détecte les informations personnellement identifiables à l'aide de Microsoft Presidio. Prend en charge plus de 40 types d'entités dans plusieurs pays et langues.

Comment ça fonctionne :

- Analyse le contenu pour détecter les entités PII en utilisant la correspondance de modèles et le NLP

- Renvoie les entités détectées avec leurs emplacements et scores de confiance

- Masque optionnellement les PII détectées dans la sortie

Configuration :

- Types de PII à détecter : Sélectionnez parmi les catégories groupées via le sélecteur modal

- Commun : Nom de personne, Email, Téléphone, Carte de crédit, Adresse IP, etc.

- USA : SSN, Permis de conduire, Passeport, etc.

- Royaume-Uni : Numéro NHS, Numéro d'assurance nationale

- Espagne : NIF, NIE, CIF

- Italie : Code fiscal, Permis de conduire, Code TVA

- Pologne : PESEL, NIP, REGON

- Singapour : NRIC/FIN, UEN

- Australie : ABN, ACN, TFN, Medicare

- Inde : Aadhaar, PAN, Passeport, Numéro d'électeur

- Mode :

- Détecter : Identifier uniquement les PII (par défaut)

- Masquer : Remplacer les PII détectées par des valeurs masquées

- Langue : Langue de détection (par défaut : anglais)

Sortie :

passed:falsesi des types de PII sélectionnés sont détectésdetectedEntities: Tableau des PII détectées avec type, emplacement et niveau de confiancemaskedText: Contenu avec PII masquées (uniquement si mode = "Mask")error: Message d'erreur si la validation échoue

Cas d'utilisation :

- Bloquer le contenu contenant des informations personnelles sensibles

- Masquer les PII avant la journalisation ou le stockage des données

- Conformité avec le RGPD, HIPAA et autres réglementations sur la confidentialité

- Assainir les entrées utilisateur avant traitement

Configuration

Contenu à valider

Le contenu d'entrée à valider. Cela provient généralement de :

- Sorties de blocs d'agent :

<agent.content> - Résultats de blocs de fonction :

<function.output> - Réponses API :

<api.output> - Toute autre sortie de bloc

Type de validation

Choisissez parmi quatre types de validation :

- JSON valide : Vérifier si le contenu est au format JSON correctement formaté

- Correspondance Regex : Vérifier si le contenu correspond à un modèle regex

- Vérification d'hallucination : Valider par rapport à une base de connaissances avec notation LLM

- Détection de PII : Détecter et éventuellement masquer les informations personnellement identifiables

Sorties

Tous les types de validation renvoient :

<guardrails.passed>: Booléen indiquant si la validation a réussi<guardrails.validationType>: Le type de validation effectuée<guardrails.input>: L'entrée originale qui a été validée<guardrails.error>: Message d'erreur si la validation a échoué (facultatif)

Sorties supplémentaires par type :

Vérification d'hallucination :

<guardrails.score>: Score de confiance (0-10)<guardrails.reasoning>: Explication du LLM

Détection de PII :

<guardrails.detectedEntities>: Tableau des entités PII détectées<guardrails.maskedText>: Contenu avec PII masquées (si mode = "Mask")

Exemples de cas d'utilisation

Valider le JSON avant l'analyse

Scénario : s'assurer que la sortie de l'agent est un JSON valide

- L'agent génère une réponse JSON structurée

- Guardrails valide le format JSON

- Le bloc de condition vérifie

<guardrails.passed> - Si réussi → Analyser et utiliser les données, Si échoué → Réessayer ou gérer l'erreur

Prévenir les hallucinations

Scénario : valider les réponses du support client

- L'agent génère une réponse à la question du client

- Guardrails vérifie par rapport à la base de connaissances de la documentation d'assistance

- Si le score de confiance ≥ 3 → Envoyer la réponse

- Si le score de confiance < 3 → Signaler pour révision humaine

Bloquer les PII dans les entrées utilisateur

Scénario : assainir le contenu soumis par l'utilisateur

- L'utilisateur soumet un formulaire avec du contenu textuel

- Guardrails détecte les PII (emails, numéros de téléphone, numéros de sécurité sociale, etc.)

- Si PII détectées → Rejeter la soumission ou masquer les données sensibles

- Si aucune PII → Traiter normalement

Valider le format d'email

Scénario : vérifier le format d'adresse email

- L'agent extrait l'email du texte

- Guardrails valide avec un modèle d'expression régulière

- Si valide → Utiliser l'email pour la notification

- Si invalide → Demander une correction

Bonnes pratiques

- Chaîner avec des blocs Condition : Utilisez

<guardrails.passed>pour créer des branches dans la logique du workflow selon les résultats de validation - Valider le JSON avant l'analyse : Toujours valider la structure JSON avant de tenter d'analyser les sorties du LLM

- Choisir les types de PII appropriés : Sélectionnez uniquement les types d'entités PII pertinents pour votre cas d'utilisation afin d'améliorer les performances

- Définir des seuils de confiance raisonnables : Pour la détection d'hallucinations, ajustez le seuil selon vos exigences de précision (plus élevé = plus strict)

- Utiliser des modèles performants pour la détection d'hallucinations : GPT-4o ou Claude 3.7 Sonnet fournissent un score de confiance plus précis

- Masquer les PII pour la journalisation : Utilisez le mode « Mask » lorsque vous devez journaliser ou stocker du contenu susceptible de contenir des PII

- Tester les modèles regex : Validez soigneusement vos modèles d'expressions régulières avant de les déployer en production

- Surveiller les échecs de validation : Suivez les messages

<guardrails.error>pour identifier les problèmes de validation courants

La validation des guardrails s'effectue de manière synchrone dans votre workflow. Pour la détection d'hallucinations, choisissez des modèles plus rapides (comme GPT-4o-mini) si la latence est critique.